广东工业大学:《机器学习》课程教学资源(课件讲义)第11讲 感知机模型与多层感知机(前馈神经网络,DNN BP)

《神经网络与深度学习》 前馈神经网络 https://nndl.github.io/

前馈神经网络 《神经⽹络与深度学习》 https://nndl.github.io/

内容 神经网络 神经元 网络结构 ↓前馈神经网络 参数学习 计算图与自动微分 ,优化问题 《神经网络与深度学习》 2

《神经⽹络与深度学习》 2 内容 }神经⽹络 }神经元 }⽹络结构 }前馈神经⽹络 }参数学习 }计算图与自动微分 }优化问题

神经网络

神经网络

神经网络 神经网络最早是作为一种主要的连接主义模型。 20世纪80年代后期,最流行的一种连接主义模型是分布式并行处理 (Parallel Distributed Processing,PDP)网络,其有3个主要特性: 1)信息表示是分布式的(非局部的); 2)记忆和知识是存储在单元之间的连接上; 3)通过逐渐改变单元之间的连接强度来学习新的知识。 引入误差反向传播来改进其学习能力之后,神经网络也越来越多地 应用在各种机器学习任务上。 《神经网络与深度学习》

《神经⽹络与深度学习》 4 神经网络 }神经⽹络最早是作为⼀种主要的连接主义模型。 }20世纪80年代后期,最流⾏的⼀种连接主义模型是分布式并⾏处理 (Parallel Distributed Processing,PDP)⽹络,其有3个主要特性: }1)信息表示是分布式的(非局部的); }2)记忆和知识是存储在单元之间的连接上; }3)通过逐渐改变单元之间的连接强度来学习新的知识。 }引⼊误差反向传播来改进其学习能⼒之后,神经⽹络也越来越多地 应用在各种机器学习任务上

神经元

神经元

生物神经元 video:structure of brain Cell body Axon Telodendria Nucleus Axon hillock Synaptic terminals Golgi apparatus Endoplasmic reticulum Mitochondrion Dendrite 单个神经细胞只有两种状 Dendritic branches 态:兴奋和抑制 《神经网络与深度学习》 6

《神经⽹络与深度学习》 6 生物神经元 单个神经细胞只有两种状 态:兴奋和抑制 video: structure of brain

人工神经元 Wixi +b =wTx+b, a f(z) 6 W1 W2 Wd 激活函数 权重 一个筒单的线性模型! 《神经网络与深度学习》 7

《神经⽹络与深度学习》 7 人工神经元 ⼀个简单的线性模型!

激活函数的性质 连续并可导(允许少数,点上不可导)的非线性函数。 可导的激活函数可以直接利用数值优化的方法来学习网络参数。 激活函数及其导函数要尽可能的简单 有利于提高网络计算效率。 激活函数的导函数的值域要在一个合适的区间内 不能太大也不能太小,否则会影响训练的效率和稳定性。 单调递增 ??2 《神经网络与深度学习》

《神经⽹络与深度学习》 8 激活函数的性质 }连续并可导(允许少数点上不可导)的非线性函数。 }可导的激活函数可以直接利用数值优化的⽅法来学习⽹络参数。 }激活函数及其导函数要尽可能的简单 }有利于提⾼⽹络计算效率。 }激活函数的导函数的值域要在⼀个合适的区间内 }不能太⼤也不能太小,否则会影响训练的效率和稳定性。 }单调递增 }???

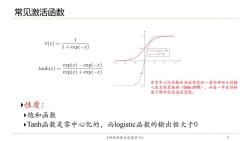

常见激活函数 ………… 1 o(x)= 1+exp(-x) 0. 一L0gsto函取 -=--Tnh雨圆 tanh(x)= exp(z)-exp(-z) exp(x)+exp(-2) 非零中心化的输出会使得其后一层的神经元的输 入发生偏置偏移(bias shift),并进一步使得梯 度下降的收敛速度变慢。 性质: 饱和函数 Tanh函数是零中心化的,而logistic函数的输出恒大于0 《神经网络与深度学习》 9

《神经⽹络与深度学习》 9 常见激活函数 非零中⼼化的输出会使得其后⼀层的神经元的输 ⼊发⽣偏置偏移(bias shift),并进⼀步使得梯 度下降的收敛速度变慢。 }性质: }饱和函数 }Tanh函数是零中⼼化的,⽽logistic函数的输出恒⼤于0

常见激活函数 x≥0 ReLU(z) ,计算上更加高效 0 x0 ELU 问题 LeakyReLU(z)= 2 (Y2 ifx≤0 if x>0 PReLU:(x) ifx≤0 -4 if x>0 ELU(z) Y(exp(e)-1)ifx≤0 =max(0,x)+min(0,y(exp(r)-1)) 死亡ReL.U问题(Dying ReLU Problem) softplus()=log(1+exp(x)) 《神经网络与深度学习》 10

《神经⽹络与深度学习》 10 常见激活函数 } 计算上更加⾼效 } ⽣物学合理性 } 单侧抑制、宽兴奋边界 } 在⼀定程度上缓解梯度消失 问题 死亡ReLU问题(Dying ReLU Problem)

按次数下载不扣除下载券;

注册用户24小时内重复下载只扣除一次;

顺序:VIP每日次数-->可用次数-->下载券;

- 广东工业大学:《机器学习》课程教学资源(课件讲义)第10讲 神经网络的优化(激活函数 dropout).pdf

- 广东工业大学:《机器学习》课程教学资源(课件讲义)第10讲 神经网络的优化(梯度消失和梯度爆炸BN).pdf

- 广东工业大学:《机器学习》课程教学资源(课件讲义)第10讲 神经网络的优化(自适应学习率 AdaGrad RMSProp).pdf

- 广东工业大学:《机器学习》课程教学资源(课件讲义)第10讲 神经网络的优化(batch和动量Momentum NAG).pdf

- 广东工业大学:《机器学习》课程教学资源(课件讲义)第9讲 神经网络的优化(梯度下降、学习率adagrad adam、随机梯度下降、特征缩放).pdf

- 广东工业大学:《机器学习》课程教学资源(课件讲义)第9讲 神经网络的优化(损失函数).pdf

- 广东工业大学:《机器学习》课程教学资源(课件讲义)第8讲 集成学习(决策树的演化).pdf

- 广东工业大学:《机器学习》课程教学资源(课件讲义)第7讲 集成学习(决策树).pdf

- 广东工业大学:《机器学习》课程教学资源(课件讲义)第6讲 线性回归模型及其求解方法 Linear Regression Model and Its Solution.pdf

- 广东工业大学:《机器学习》课程教学资源(课件讲义)第5讲 分类问题(4.4 朴素?叶斯分类器).pdf

- 广东工业大学:《机器学习》课程教学资源(课件讲义)第5讲 分类问题(4.3 ?持向量机 SVM).pdf

- 广东工业大学:《机器学习》课程教学资源(课件讲义)第4讲 分类问题(4.1 分类与回归问题概述 4.2 分类性能度量?法).pdf

- 广东工业大学:《机器学习》课程教学资源(课件讲义)第3讲 特征工程 Feature Engineering.pdf

- 广东工业大学:《机器学习》课程教学资源(课件讲义)第2讲 模型评估与选择.pdf

- 广东工业大学:《机器学习》课程教学资源(课件讲义)第1讲 机器学习概述.pdf

- 《机器学习》课程教学资源:《大语言模型》参考书籍PDF电子版 THE CHINESE BOOK FOR LARGE LANGUAGE MODELS(共十三章).pdf

- 《机器学习》课程教学资源:《Python数据科学手册》参考书籍PDF电子版(2016)Python Data Science Handbook,Essential Tools for Working with Data,Jake VanderPlas.pdf

- 《机器学习》课程教学资源:《统计学习方法》参考书籍PDF电子版(清华大学出版社,第2版,共22章,作者:李航).pdf

- 《机器学习》课程教学资源:《神经网络与深度学习》参考书籍PDF电子版 Neural Networks and Deep Learning(共十五章).pdf

- 《机器学习》课程教学资源:《机器学习》参考书籍PDF电子版(清华大学出版社,著:周志华).pdf

- 广东工业大学:《机器学习》课程教学资源(课件讲义)第12讲 卷积神经网络(卷积和池化层).pdf

- 广东工业大学:《机器学习》课程教学资源(课件讲义)第12讲 卷积神经网络(LeNet, AlexNet, VGG和NiN).pdf

- 广东工业大学:《机器学习》课程教学资源(课件讲义)第13讲 卷积神经网络计算机视觉应用(Inception, 批量归一化和残差网络ResNet).pdf

- 广东工业大学:《机器学习》课程教学资源(课件讲义)第13讲 卷积神经网络计算机视觉应用(目标检测,计算机视觉训练技巧).pdf

- 广东工业大学:《机器学习》课程教学资源(课件讲义)第14讲 循环神经网络(RNN).pdf

- 广东工业大学:《机器学习》课程教学资源(课件讲义)第15讲 无监督学习——降维深度学习可视化(PCA Kmeans).pdf

- 广东工业大学:《机器学习》课程教学资源(课件讲义)第15讲 无监督学习——降维深度学习可视化(Neighbor Embedding,LLE T-SNE).pdf

- 广东工业大学:《机器学习》课程教学资源(PPT讲稿)第16讲 现代循环神经网络(高级循环神经网络).pptx

- 广东工业大学:《机器学习》课程教学资源(PPT讲稿)第16讲 现代循环神经网络(编码器解码器,Seq2seq模型,束搜索).pptx

- 广东工业大学:《机器学习》课程教学资源(PPT讲稿)第16讲 现代循环神经网络(嵌入向量, 词嵌入, 子词嵌入, 全局向量的词嵌入).pptx

- 广东工业大学:《机器学习》课程教学资源(PPT讲稿)第17讲 注意力机制(概述).pptx

- 广东工业大学:《机器学习》课程教学资源(课件讲义)第17讲 注意力机制(自注意力).pdf

- 广东工业大学:《机器学习》课程教学资源(PPT讲稿)第18讲 变换器模型 Transformer.pptx

- 广东工业大学:《机器学习》课程教学资源(课件讲义)第18讲 变换器模型 Transformer.pdf

- 广东工业大学:《机器学习》课程教学资源(课件讲义)第19讲 ViT及注意力机制改进(Vision Transformers ,ViTs).pdf

- 广东工业大学:《机器学习》课程教学资源(课件讲义)第19讲 ViT及注意力机制改进(各式各样的Attention).pdf

- 广东工业大学:《机器学习》课程教学资源(课件讲义)第20讲 预训练模型 Pre-training of Deep Bidirectional Transformers for Language Understanding(授课:周郭许).pdf

- 广东工业大学:《机器学习》课程教学资源(课件讲义)第21讲 生成式网络模型(自编码器 Deep Auto-encoder).pdf

- 广东工业大学:《机器学习》课程教学资源(课件讲义)第21讲 生成式网络模型(VAE Generation).pdf

- 广东工业大学:《机器学习》课程教学资源(课件讲义)第22讲 生成式网络模型(Diffusion Model).pdf