广东工业大学:《机器学习》课程教学资源(课件讲义)第10讲 神经网络的优化(自适应学习率 AdaGrad RMSProp)

Error surface is rugged .. Tips for training:Adaptive Learning Rate

Error surface is rugged … Tips for training: Adaptive Learning Rate 1

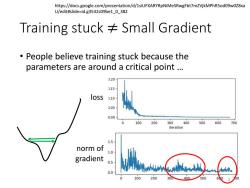

https://docs.google.com/presentation/d/1siUFXARYRpNiMeSRwgFbt7mZVjkMPhR5od09w0Z8xa U/edit#slide=id.g3532c09be1_0_382 Training stuck Small Gradient People believe training stuck because the parameters are around a critical point .. 0.20 .15 loss 1.10 3.05 0.00 100 200 300400500600 700 iteration 1.5 norm of 1.0 gradient 0.5 0.0 100 200 30 400 500

Training stuck ≠ Small Gradient • People believe training stuck because the parameters are around a critical point … loss norm of gradient https://docs.google.com/presentation/d/1siUFXARYRpNiMeSRwgFbt7mZVjkMPhR5od09w0Z8xa U/edit#slide=id.g3532c09be1_0_382 2

Wait a minute... 0.10 0.08 0.06 造o04 0.02 0.00 ·86。 0.0 0.1 0.2 0.3 0.4 0.5 minimum ratio

Wait a minute … 3

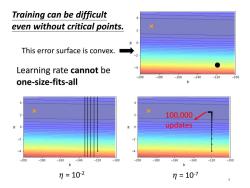

Training can be difficult even without critical points. This error surface is convex. Learning rate cannot be -200 -180 -160 -140 -120 -100 one-size-fits-all 6 X 100,000 0 updates 200 -180 -160 -140 -120 -100 -200 -180 -160 -140 -120 -100 b b 7=102 7=107 4

100,000 updates 𝜂 = 10-2 Learning rate cannot be one-size-fits-all Training can be difficult even without critical points. 𝜂 = 10-7 4 This error surface is convex

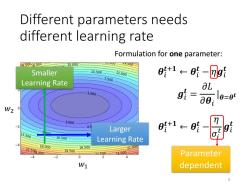

Different parameters needs different learning rate Formulation for one parameter: 650018.000 15.000 x3500 Smaller 10.500 12.000 0+1←01-⑦g1 7.500 Learning Rate aL 1500 g1=∂01 0=09 W2 0 3.000 Larger 时t1←时 13.500 00a 10.500 Learning Rate 18.000 22.50400m 16.500 19.500 21.000 5000 Parameter dependent

Different parameters needs different learning rate 𝑤1 𝑤2 Larger Learning Rate Smaller Learning Rate 𝜽𝑖 𝒕+𝟏 ← 𝜽𝑖 𝒕 − 𝜂𝒈𝑖 𝒕 𝜽𝑖 𝒕+𝟏 ← 𝜽𝑖 𝒕 − 𝜂 𝜎𝑖 𝑡 𝒈𝑖 𝒕 Parameter dependent 𝒈𝑖 𝒕 = 𝜕𝐿 𝜕𝜽𝑖 |𝜽=𝜽 𝒕 Formulation for one parameter: 5

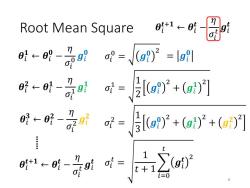

Root Mean Square 时←明-是a时-o-l n a脱←a}- =2g+()] 0←- n =g92+(2+(g)1 0+1← -71 6

Root Mean Square 𝜎𝑖 0 = 𝒈𝑖 𝟎 2 𝜎𝑖 1 = 1 2 𝒈𝑖 𝟎 2 + 𝒈𝑖 𝟏 2 𝜎𝑖 𝑡 = 1 𝑡 + 1 𝑖=0 𝑡 𝒈𝑖 𝒕 2 𝜎𝑖 2 = 1 3 𝒈𝑖 𝟎 2 + 𝒈𝑖 𝟏 2 + 𝒈𝑖 𝟐 2 𝜽𝑖 𝟏 ← 𝜽𝑖 𝟎 − 𝜂 𝜎𝑖 0 𝒈𝑖 𝟎 𝜽𝑖 𝒕+𝟏 ← 𝜽𝑖 𝒕 − 𝜂 𝜎𝑖 𝑡 𝒈𝑖 𝒕 𝜽𝑖 𝟐 ← 𝜽𝑖 𝟏 − 𝜂 𝜎𝑖 1 𝒈𝑖 𝟏 𝜽𝑖 𝟑 ← 𝜽𝑖 𝟐 − 𝜂 𝜎𝑖 2 𝒈𝑖 𝟐 𝜽𝑖 𝒕+𝟏 ← 𝜽𝑖 𝒕 − 𝜂 𝜎𝑖 𝑡 𝒈𝑖 𝒕 …… 6 = 𝒈𝑖 𝟎

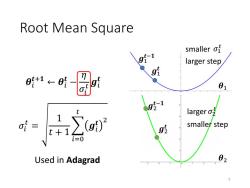

Root mean square 9f1 smaller of larger step gl 01 g51 larger g smaller step i=0 Used in Adagrad 02 7

Root Mean Square 𝜎𝑖 𝑡 = 1 𝑡 + 1 𝑖=0 𝑡 𝒈𝑖 𝒕 2 𝜽𝑖 𝒕+𝟏 ← 𝜽𝑖 𝒕 − 𝜂 𝜎𝑖 𝑡 𝒈𝑖 𝒕 𝜽1 𝜽2 𝒈1 𝒕−𝟏 𝒈1 𝒕 𝒈2 𝒕−𝟏 𝒈2 𝒕 smaller 𝜎1 𝑡 larger𝜎2 𝑡 larger step smaller step Used in Adagrad 7

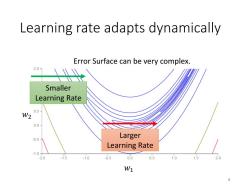

Learning rate adapts dynamically Error Surface can be very complex. Smaller Learning Rate 0.5 W2 0.0 -0.5 Larger Learning Rate -10 2.0 1.5 -1.0 0.5 0.0 0.5 1.0 1.5 W1 8

Learning rate adapts dynamically 𝑤1 𝑤2 Error Surface can be very complex. Larger Learning Rate Smaller Learning Rate 8

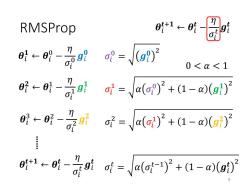

RMSProp 41←明9 0<<1 o=Va(o)2+(1-a(gi)2 0明←-2听=Va(}'+1-a(g) a1←时-是0时时-(a时-y+1-o

RMSProp 𝜎𝑖 0 = 𝒈𝑖 𝟎 2 𝜎𝑖 1 = 𝛼 𝜎𝑖 0 2 + 1 − 𝛼 𝒈𝑖 𝟏 2 𝜎𝑖 𝑡 = 𝛼 𝜎𝑖 𝑡−1 2 + 1 − 𝛼 𝒈𝑖 𝒕 2 𝜎𝑖 2 = 𝛼 𝜎𝑖 1 2 + 1 − 𝛼 𝒈𝑖 𝟐 2 𝜽𝑖 𝟏 ← 𝜽𝑖 0 − 𝜂 𝜎𝑖 0 𝒈𝑖 𝟎 𝜽𝑖 𝒕+𝟏 ← 𝜽𝑖 𝒕 − 𝜂 𝜎𝑖 𝑡 𝒈𝑖 𝒕 𝜽𝑖 𝟐 ← 𝜽𝑖 1 − 𝜂 𝜎𝑖 1 𝒈𝑖 𝟏 𝜽𝑖 3 ← 𝜽𝑖 2 − 𝜂 𝜎𝑖 2 𝒈𝑖 𝟐 𝜽𝑖 𝒕+𝟏 ← 𝜽𝑖 𝒕 − 𝜂 𝜎𝑖 𝑡 𝒈𝑖 𝒕 …… 0 < 𝛼 < 1 9

RMSProp g}g1…g51 0<0<1 1←时圆a=、aa-yP+1-wa The recent gradient has larger influence, and the past gradients have less influence. small of increase of larger step smaller step decrease of larger step 10

RMSProp 𝜽𝑖 𝒕+𝟏 ← 𝜽𝑖 𝒕 − 𝜂 𝜎𝑖 𝑡 𝒈𝑖 𝒕 increase 𝜎𝑖 𝑡 decrease 𝜎𝑖 𝑡 smaller step larger step 𝜎𝑖 𝑡 = 𝛼 𝜎𝑖 𝑡−1 2 + 1 − 𝛼 𝒈𝑖 𝒕 2 0 < 𝛼 < 1 The recent gradient has larger influence, and the past gradients have less influence. small 𝜎𝑖 𝑡 larger step 10 𝒈𝑖 𝟏 𝒈𝑖 𝟐 …… 𝒈𝑖 𝒕−𝟏

按次数下载不扣除下载券;

注册用户24小时内重复下载只扣除一次;

顺序:VIP每日次数-->可用次数-->下载券;

- 广东工业大学:《机器学习》课程教学资源(课件讲义)第10讲 神经网络的优化(batch和动量Momentum NAG).pdf

- 广东工业大学:《机器学习》课程教学资源(课件讲义)第9讲 神经网络的优化(梯度下降、学习率adagrad adam、随机梯度下降、特征缩放).pdf

- 广东工业大学:《机器学习》课程教学资源(课件讲义)第9讲 神经网络的优化(损失函数).pdf

- 广东工业大学:《机器学习》课程教学资源(课件讲义)第8讲 集成学习(决策树的演化).pdf

- 广东工业大学:《机器学习》课程教学资源(课件讲义)第7讲 集成学习(决策树).pdf

- 广东工业大学:《机器学习》课程教学资源(课件讲义)第6讲 线性回归模型及其求解方法 Linear Regression Model and Its Solution.pdf

- 广东工业大学:《机器学习》课程教学资源(课件讲义)第5讲 分类问题(4.4 朴素?叶斯分类器).pdf

- 广东工业大学:《机器学习》课程教学资源(课件讲义)第5讲 分类问题(4.3 ?持向量机 SVM).pdf

- 广东工业大学:《机器学习》课程教学资源(课件讲义)第4讲 分类问题(4.1 分类与回归问题概述 4.2 分类性能度量?法).pdf

- 广东工业大学:《机器学习》课程教学资源(课件讲义)第3讲 特征工程 Feature Engineering.pdf

- 广东工业大学:《机器学习》课程教学资源(课件讲义)第2讲 模型评估与选择.pdf

- 广东工业大学:《机器学习》课程教学资源(课件讲义)第1讲 机器学习概述.pdf

- 《机器学习》课程教学资源:《大语言模型》参考书籍PDF电子版 THE CHINESE BOOK FOR LARGE LANGUAGE MODELS(共十三章).pdf

- 《机器学习》课程教学资源:《Python数据科学手册》参考书籍PDF电子版(2016)Python Data Science Handbook,Essential Tools for Working with Data,Jake VanderPlas.pdf

- 《机器学习》课程教学资源:《统计学习方法》参考书籍PDF电子版(清华大学出版社,第2版,共22章,作者:李航).pdf

- 《机器学习》课程教学资源:《神经网络与深度学习》参考书籍PDF电子版 Neural Networks and Deep Learning(共十五章).pdf

- 《机器学习》课程教学资源:《机器学习》参考书籍PDF电子版(清华大学出版社,著:周志华).pdf

- 《机器学习》课程教学资源:《动手学深度学习》参考书籍PDF电子版 Release 2.0.0-beta0(共十六章).pdf

- 西北农林科技大学:《Visual Basic程序设计基础》课程教学资源(PPT课件)第07章 数据文件.ppt

- 西北农林科技大学:《Visual Basic程序设计基础》课程教学资源(PPT课件)第06章 模块化程序设计.ppt

- 广东工业大学:《机器学习》课程教学资源(课件讲义)第10讲 神经网络的优化(梯度消失和梯度爆炸BN).pdf

- 广东工业大学:《机器学习》课程教学资源(课件讲义)第10讲 神经网络的优化(激活函数 dropout).pdf

- 广东工业大学:《机器学习》课程教学资源(课件讲义)第11讲 感知机模型与多层感知机(前馈神经网络,DNN BP).pdf

- 广东工业大学:《机器学习》课程教学资源(课件讲义)第12讲 卷积神经网络(卷积和池化层).pdf

- 广东工业大学:《机器学习》课程教学资源(课件讲义)第12讲 卷积神经网络(LeNet, AlexNet, VGG和NiN).pdf

- 广东工业大学:《机器学习》课程教学资源(课件讲义)第13讲 卷积神经网络计算机视觉应用(Inception, 批量归一化和残差网络ResNet).pdf

- 广东工业大学:《机器学习》课程教学资源(课件讲义)第13讲 卷积神经网络计算机视觉应用(目标检测,计算机视觉训练技巧).pdf

- 广东工业大学:《机器学习》课程教学资源(课件讲义)第14讲 循环神经网络(RNN).pdf

- 广东工业大学:《机器学习》课程教学资源(课件讲义)第15讲 无监督学习——降维深度学习可视化(PCA Kmeans).pdf

- 广东工业大学:《机器学习》课程教学资源(课件讲义)第15讲 无监督学习——降维深度学习可视化(Neighbor Embedding,LLE T-SNE).pdf

- 广东工业大学:《机器学习》课程教学资源(PPT讲稿)第16讲 现代循环神经网络(高级循环神经网络).pptx

- 广东工业大学:《机器学习》课程教学资源(PPT讲稿)第16讲 现代循环神经网络(编码器解码器,Seq2seq模型,束搜索).pptx

- 广东工业大学:《机器学习》课程教学资源(PPT讲稿)第16讲 现代循环神经网络(嵌入向量, 词嵌入, 子词嵌入, 全局向量的词嵌入).pptx

- 广东工业大学:《机器学习》课程教学资源(PPT讲稿)第17讲 注意力机制(概述).pptx

- 广东工业大学:《机器学习》课程教学资源(课件讲义)第17讲 注意力机制(自注意力).pdf

- 广东工业大学:《机器学习》课程教学资源(PPT讲稿)第18讲 变换器模型 Transformer.pptx

- 广东工业大学:《机器学习》课程教学资源(课件讲义)第18讲 变换器模型 Transformer.pdf

- 广东工业大学:《机器学习》课程教学资源(课件讲义)第19讲 ViT及注意力机制改进(Vision Transformers ,ViTs).pdf

- 广东工业大学:《机器学习》课程教学资源(课件讲义)第19讲 ViT及注意力机制改进(各式各样的Attention).pdf

- 广东工业大学:《机器学习》课程教学资源(课件讲义)第20讲 预训练模型 Pre-training of Deep Bidirectional Transformers for Language Understanding(授课:周郭许).pdf