西安邮电大学:《信息论与编码》课程教学课件(PPT讲稿)第二章 信源与信息熵

第二章信源与信息熵 2.1信源的数学模型及分类 。2.2离散信源熵和互信息 2.3信息熵的性质 。2.4离散序列信源熵 ·2.5连续信源熵与互信息 ÷2.6信源的冗余度

第二章 信源与信息熵 ❖ 2.1 信源的数学模型及分类 ❖ 2.2 离散信源熵和互信息 ❖ 2.3 信息熵的性质 ❖ 2.4 离散序列信源熵 ❖ 2.5 连续信源熵与互信息 ❖ 2.6 信源的冗余度

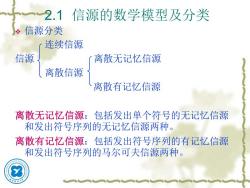

2.1 信源的数学模型及分类 。信源分类 连续信源 信源 离散无记忆信源 离散信源 离散有记忆信源 离散无记忆信源:包括发出单个符号的无记忆信源 和发出符号序列的无记忆信源两种。 离散有记忆信源:包括发出符号序列的有记忆信源 和发出符号序列的马尔可夫信源两种

2.1 信源的数学模型及分类 ❖ 信源分类 连续信源 信源 离散无记忆信源 离散信源 离散有记忆信源 离散无记忆信源:包括发出单个符号的无记忆信源 和发出符号序列的无记忆信源两种。 离散有记忆信源:包括发出符号序列的有记忆信源 和发出符号序列的马尔可夫信源两种

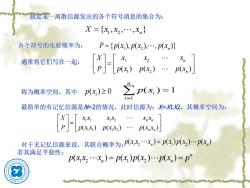

假定某一离散信源发出的各个符号消息的集合为: X={x1,x2,.,Xn} 各个符号的先验概率为: P={p(x),p(x2),.,p(xn)} 通常将它们写在一起: 称为概率空间,其中 p(x)≥20 p(x,)=1 i=1 最简单的有记忆信源是=2的情况,此时信源为:仁Ⅺ2,其概率空间为: xx XX2 . XnXn p(xx)p(xx2). p(xx) 对于无记忆信源来说,其联合概率为:p.x)=px)p(x).px,) 若其满足平稳性: p(xx2.xn)=p(x)px2).pxn)=p

各个符号的先验概率为: 1 2 { , , , } X x x x = n 假定某一离散信源发出的各个符号消息的集合为: 1 2 { ( ), ( ), , ( )} P p x p x p x = n 通常将它们写在一起: 称为概率空间,其中 最简单的有记忆信源是N=2的情况,此时信源为:X=X1X2,其概率空间为: 对于无记忆信源来说,其联合概率为: 若其满足平稳性: 1 2 1 2 ( ) ( ) ( ) n n X x x x P p x p x p x = ( ) 0 i p x 1 ( ) 1 n i i p x = = 1 1 1 2 1 1 1 2 ( ) ( ) ( ) n n n n X x x x x x x P p x x p x x p x x = 1 2 1 2 ( ) ( ) ( ) ( ) n n p x x x p x p x p x = 1 2 1 2 ( ) ( ) ( ) ( ) n n n p x x x p x p x p x p = =

更一般情况:随机波形信源 ÷实际信源输出的消息常常是时间和取值都是连续 的。这类信源称为随机波形信源。 ÷随机波形信源在某一固定时间o的可能取值是连 续和随机的。对于这种信源输出的消息,可用随 机过程来描述。 ÷例:语音信号X()、热噪声信号n(①)、电视图像信 号X(r(),g(①),b()等时间连续函数

更一般情况:随机波形信源 ❖ 实际信源输出的消息常常是时间和取值都是连续 的。这类信源称为随机波形信源。 ❖ 随机波形信源在某一固定时间 t0 的可能取值是连 续和随机的。对于这种信源输出的消息,可用随 机过程来描述。 ❖ 例:语音信号X(t)、热噪声信号n(t)、电视图像信 号X(r(t),g(t),b(t))等时间连续函数

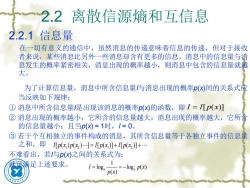

2.2离散信源熵和互信息 2.2.1信息量 在一切有意义的通信中,虽然消息的传递意味着信息的传递,但对于接收 者来说,某些消息比另外一些消息却含有更多的信息。消息中的信息量与消 息发生的概率紧密相关,消息出现的概率越小,则消息中包含的信息量就越 大。 为了计算信息量,消息中所含信息量与消息出现的概率(X间的关系式应 当反映如下规律: ①消息中所含信息量偍出现该消息的概率p(X的函数,即I=I[p(x)] ②消息出现的概率越小,它所含的信息量越大;消息出现的概率越大,它所含 的信息量越小;且当p(X)=1时,/=0。 ③若干个互相独立的事件构成的消息,其所含信息量等于各独立事件的信息量 之和,即[p(x)p(x2)=[px】+Lpx】+. 不难看出,若与p(X)之间的关系式为: 满足上述要求。 I=loga p(x) =-loga p(x)

2.2 离散信源熵和互信息 2.2.1 信息量 在一切有意义的通信中,虽然消息的传递意味着信息的传递,但对于接收 者来说,某些消息比另外一些消息却含有更多的信息。消息中的信息量与消 息发生的概率紧密相关,消息出现的概率越小,则消息中包含的信息量就越 大。 为了计算信息量,消息中所含信息量I与消息出现的概率p(x)间的关系式应 当反映如下规律: ① 消息中所含信息量I是出现该消息的概率p(x)的函数,即 ② 消息出现的概率越小,它所含的信息量越大;消息出现的概率越大,它所含 的信息量越小;且当p(x) = 1时,I = 0。 ③ 若干个互相独立的事件构成的消息,其所含信息量等于各独立事件的信息量 之和,即 不难看出,若I与p(x)之间的关系式为: 就可满足上述要求。 I I p x = [ ( )] 1 2 1 2 I p x p x I p x I p x [ ( ) ( ) ] [ ( )] [ ( )] = + + 1 log log ( ) ( ) a a I p x p x = = −

点说明 ÷计算自信息量时要注意有关事件发生概率的计算; 自信息量的单位取决于对数的底; s底为2,单位为“比特(bit,binary unit) ” s底为e,单位为“奈特(nat,nature unit) 6底为l0,单位为“哈特(hat,Hartley)” 6根据换底公式得: l10g。X= logX log a 1 nat=1.44bit,1 hat=3.32 bit; 般计算都采用以“2”为底的对数,为了书写简洁 常把底数“2”略去不写

一点说明 ❖ 计算自信息量时要注意有关事件发生概率的计算; ❖ 自信息量的单位取决于对数的底; 底为2,单位为“比特(bit, binary unit)”; 底为e,单位为“奈特(nat, nature unit)”; 底为10,单位为“哈特(hat, Hartley)”; 根据换底公式得: a X X b b a log log log = ◼ 一般计算都采用以“2”为底的对数,为了书写简洁, 常把底数“2”略去不写 1 nat = 1.44bit , 1 hat = 3.32 bit;

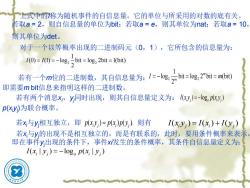

上式中的称为随机事件的自信息量。它的单位与所采用的对数的底有关。 若取a=2,则自信息量的单位为bit;若取a=e,则其单位为nat;若取a=10, 则其单位为det。 对于一个以等概率出现的二进制码元(0,1),它所包含的信息量为: 1(0)=I(1)=-log:bit=log,2bit=l(bit) 若有个m位的二进制数,其自信息量为:1=-lg:六bi=1e,2"b=mb 即需要mbit信息来指明这样的二进制数。 若有两个消息x,y同时出现,则其自信息量定义为:I(y)=-lgPy) p(y)为联合概率。 若x与y相互独立,即pxy)=px)Py)则有 I(x;y)=1(x)+1(y 若x与y的出现不是相互独立的,而是有联系的,此时,要用条件概率来表示 即在事件y出现的条件下,事件x发生的条件概率,其条件自信息量定义为: I(x;y)=-loga p(xy)

上式中的I称为随机事件的自信息量。它的单位与所采用的对数的底有关。 若取a = 2,则自信息量的单位为bit;若取a = e,则其单位为nat;若取a = 10, 则其单位为det。 对于一个以等概率出现的二进制码元(0,1),它所包含的信息量为: 若有一个m位的二进制数,其自信息量为: 即需要m bit信息来指明这样的二进制数。 若有两个消息xi,yj同时出现,则其自信息量定义为: p(xiyj )为联合概率。 若xi与yj相互独立,即 ,则有 若xi与yj的出现不是相互独立的,而是有联系的,此时,要用条件概率来表示, 即在事件yj出现的条件下,事件xi发生的条件概率,其条件自信息量定义为: 2 2 1 (0) (1) log bit log 2bit 1(bit) 2 I I = = − = = 2 2 1 log bit log 2 bit (bit) 2 m m I m = − = = ( ) log ( ) i j a i j I x y p x y = − ( ) ( ) ( ) i j i j p x y p x p y ( ) ( ) ( ) i j i j = I x y I x I y = + ( | ) log ( | ) i j a i j I x y p x y = −

例题2-1英文字母中“a”出现的概率为0.063,“c”出现的概率为0.023,“e” 出现的概率为0.105,分别计算它们的自信息量。 解:由自信息量的定义式,有 1(a)=-l0g2 0.063bit=3.96bit I(c)=-log,0.023bit 5.44bit I(e)=-log2 0.105bit =3.25bit 例题2-2将二信息分别编码为A和B进行传送,在接收端,A被误收作B的概 率为0.02;而B被误收作A的概率为0.01,A与B传送的频繁程度为2:1。若 接收端收到的是A,计算原发信息是A的条件自信息量。 解:设U0表示发送A,U1表示发送B;V0表示接收A,V1表示接收B。 由题意知: p(Uo)= 2-3 )-3 p1U)=0.02 p(Vo1Uo)=0.98 p%IU)=0.99 p(V1U)=0.01

例题2-1 英文字母中“a”出现的概率为0.063,“c”出现的概率为0.023,“e” 出 现的概率为0.105,分别计算它们的自信息量。 解: 由自信息量的定义式,有 例题2-2 将二信息分别编码为A和B进行传送,在接收端,A被误收作B的概 率为0.02;而B被误收作A的概率为0.01,A与B传送的频繁程度为2:1。若 接收端收到的是A,计算原发信息是A的条件自信息量。 解:设U0表示发送A,U1表示发送B;V0表示接收A,V1表示接收B。 由题意知: 2 I a( ) log 0.063bit 3.96bit = − = 2 I c( ) log 0.023bit 5.44bit = − = 2 I e( ) log 0.105bit 3.25bit = − = 0 2 ( ) 3 p U = 1 1 ( ) 3 p U = 1 0 p V U ( | ) 0.02 = 0 0 p V U ( | ) 0.98 = 0 1 p V U ( | ) 0.01 = 1 1 p V U ( | ) 0.99 = , , ,

则接收到A时,原发信息是A的条件概率为: p(U)=(o) p(VolU)p(Uo) p(Vo) p(Vo) p(VolU)p(Uo) pVU)p(U)+pVU)p(U) 0.98×2 098×2+0.01×3 2 3 196 197

则接收到A时,原发信息是A的条件概率为: 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 1 1 ( ) ( | ) ( ) ( | ) ( ) ( ) ( | ) ( ) ( | ) ( ) ( | ) ( ) 2 0.98 3 2 1 0.98 0.01 3 3 196 197 p U V p V U p U p U V p V p V p V U p U p V U p U p V U p U = = = + = + =

2.2.2离散信源熵 假设离散信息源是一个由个符号组成的集合,称为符号集。符号集 中每一个符号x在消息中是按一定的概率p()独立出现,其概率空间为: X 且有:∑p(x)=1则,x,.x所包含的信息量分别为: -10g2 p(x),-10g2 p(x2),.,-10g2 p(x) 于是,每个符号所含信息量的统计平均值,即平均信息量为 H(X)=p(x儿-log2px】+p(x2儿-log2px2】+.+pxn)[-log2p(xn】 =-∑pPx)log,px) i=1 由于H同热力学中的熵形式相似,故通常又称它为信息源的熵,简称 匍源熵,其单位为bit/符号

2.2.2 离散信源熵 假设离散信息源是一个由n个符号组成的集合,称为符号集。符号集 中每一个符号xi在消息中是按一定的概率p(xi)独立出现,其概率空间为: 且有: 。则 所包含的信息量分别为: 于是,每个符号所含信息量的统计平均值,即平均信息量为 由于H同热力学中的熵形式相似,故通常又称它为信息源的熵,简称 信源熵,其单位为bit/符号。 1 2 1 2 ( ) ( ) ( ) n n X x x x P p x p x p x = 1 ( ) 1 n i i p x = = 1 2 , , n x x x 2 1 2 2 2 log ( ), log ( ), , log ( ) − − − p x p x p xn 1 2 1 2 2 2 2 2 1 ( ) ( )[ log ( )] ( )[ log ( )] ( )[ log ( )] ( )log ( ) n n n i i i H X p x p x p x p x p x p x p x p x = = − + − + + − = −

按次数下载不扣除下载券;

注册用户24小时内重复下载只扣除一次;

顺序:VIP每日次数-->可用次数-->下载券;

- 西安邮电大学:《信息论与编码》课程教学课件(PPT讲稿)第一章 绪论(主讲:王军选).ppt

- 《信息论与编码》课程教学资源(作业习题)第三章 信道与信道容量(含解答).pdf

- 《信息论与编码》课程教学资源(作业习题)自测题无答案.pdf

- 《信息论与编码》课程教学实验指导书.pdf

- 《信息论与编码》课程教学大纲 Element of Information Theory and Coding B.pdf

- 《信息论与编码》课程教学大纲 Element of Information Theory and Coding A.pdf

- 《信息安全概论》课程教学资源(PPT课件)第9章 信息安全标准与法律法规.ppt

- 《信息安全概论》课程教学资源(PPT课件)第2章 信息保密技术.ppt

- 《信息安全概论》课程教学资源(PPT课件)第7章 网络安全技术.ppt

- 《信息安全概论》课程教学资源(PPT课件)第8章 信息安全管理.ppt

- 《信息安全概论》课程教学资源(PPT课件)第6章 访问控制技术.ppt

- 《信息安全概论》课程教学资源(PPT课件)第5章 操作系统与数据库安全.ppt

- 《信息安全概论》课程教学资源(PPT课件)第1章 绪论.ppt

- 《信息安全概论》课程教学资源(PPT课件)第3章 信息认证技术.ppt

- 《信息安全概论》课程教学资源(PPT课件)第4章 信息隐藏技术.ppt

- 西安邮电大学:《信息安全概论》课程教学资源(教材书籍,共九章,人民邮电出版社,主编:张雪峰).pdf

- 西安邮电大学:《信息安全概论》课程教学大纲 Introduction to Information Security.doc

- 《三维动画设计》课程教学课件(PPT讲稿)第一章 三维动画设计课程介绍.ppt

- 《三维动画设计》课程教学课件(PPT讲稿)第二章 3ds max2010用户界面.ppt

- 《三维动画设计》课程教学课件(PPT讲稿)第四章 对象的变换.ppt

- 西安邮电大学:《信息论与编码》课程教学课件(PPT讲稿)第三章.ppt

- 《C++面向对象程序设计》课程教学资源(PPT课件)Chapter 4 Parameters and Overloading.ppt

- 《C++面向对象程序设计》课程教学资源(PPT课件)Chapter 1 C++ Basics.ppt

- 《C++面向对象程序设计》课程教学资源(PPT课件)Chapter 3 Function Basics.ppt

- 《C++面向对象程序设计》课程教学资源(PPT课件)Chapter 2 Flow of Control.ppt

- 《C++面向对象程序设计》课程教学资源(PPT课件)Chapter 6 Structures and Classes.ppt

- 《C++面向对象程序设计》课程教学资源(PPT课件)Chapter 7 Constructors and Other Tools.ppt

- 《C++面向对象程序设计》课程教学资源(PPT课件)Chapter 8 Operator Overloading, Friends, and References.ppt

- 《C++面向对象程序设计》课程教学资源(PPT课件)Chapter 5 Arrays.ppt

- 《C++面向对象程序设计》课程教学资源(PPT课件)Chapter 11 Separate Compilation and Namespaces.ppt

- 《C++面向对象程序设计》课程教学资源(PPT课件)Chapter 12 Streams and File IO.ppt

- 《C++面向对象程序设计》课程教学资源(PPT课件)Chapter 10 Pointers and Dynamic Arrays.ppt

- 《C++面向对象程序设计》课程教学资源(PPT课件)Chapter 9 Strings.ppt

- 《C++面向对象程序设计》课程教学资源(PPT课件)Chapter 13 Inheritance.ppt

- 《C++面向对象程序设计》课程教学资源(PPT课件)Chapter 14 Polymorphism and Virtual Functions.ppt

- 《微机技术及应用》课程教学大纲 Microcmputer Technology and aplications.doc

- 《微型计算机技术及应用》课程电子教案(PPT教学课件,共十五章,完整版).pptx

- 《计算机导论》课程教学大纲 Computer Concepts.pdf

- 《计算机导论》课程教学课件(英文讲稿)1-a-Computer History+ Di Devices.pdf

- 《计算机导论》课程教学课件(英文讲稿)1-b-Digital Data Representation.pdf