《数学模型与数学实验》课程书籍文献(数学建模算法大全)第12章 回归分析

第十二章回归分析 前面我们讲过曲线拟合问题。曲线拟合问题的特点是,根据得到的若干有关变量的 组数据,寻找因变量与(一个或几个)自变量之间的一个函数,使这个函数对那组数 据拟合得最好。通常, 函数的形式可以由经验、先验知识或对数据的直观观察决定,要 小二乘法计算函数中的待定系数。从计算的角度看,问题似乎已 决红:还有进 都是随机变量,我们根据一个样本计算出的那些 点,么数的计值是没有多大意义 假可以用方差分析 方法对模型的误差进行分析,对拟合的优劣给出评价。简单地说,回归分析就是对拟合 问题作的统计分析。 具体地说,回归分析在一组数据的基础上研究这样几个问题: (i)建立因变量y与自变量x,x2,.,xm之间的回归模型(经验公式): ()对回归模型的可信度进行检验 ()判断每个自变最x,=12,m)对y的影响是香显若: ()诊断回归模型是否适合这组数据: (v)利用回归模型对v进行预报或控制 §1数据表的基础知识 在本中 ,我们所涉及的均是样本点×变量类型的数据表 如果有m个变量 ,2,.,xm,对它们分别进行了次采样(或观测),得到n个样本点 (x1,x2,.,xm),i=1,2,.,n 则所构成的数据表X可以写成 一个n×m维的矩阵。 e X=()n= 式中e,=(x,x2,.,xm)Y∈Rm,i=1,2,.,n,e,被称为第i个样本点。 样本的均值为 样本协方差矩阵及样本相关系数矩阵分别为 S=(Sy)m= 2e.-e:- R=()m 其中 -226-

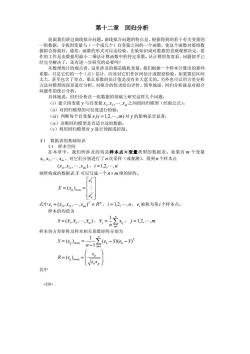

-226- 第十二章 回归分析 前面我们讲过曲线拟合问题。曲线拟合问题的特点是,根据得到的若干有关变量的 一组数据,寻找因变量与(一个或几个)自变量之间的一个函数,使这个函数对那组数 据拟合得最好。通常,函数的形式可以由经验、先验知识或对数据的直观观察决定,要 作的工作是由数据用最小二乘法计算函数中的待定系数。从计算的角度看,问题似乎已 经完全解决了,还有进一步研究的必要吗? 从数理统计的观点看,这里涉及的都是随机变量,我们根据一个样本计算出的那些 系数,只是它们的一个(点)估计,应该对它们作区间估计或假设检验,如果置信区间 太大,甚至包含了零点,那么系数的估计值是没有多大意义的。另外也可以用方差分析 方法对模型的误差进行分析,对拟合的优劣给出评价。简单地说,回归分析就是对拟合 问题作的统计分析。 具体地说,回归分析在一组数据的基础上研究这样几个问题: (i)建立因变量 y 与自变量 m x , x , , x 1 2 L 之间的回归模型(经验公式); (ii)对回归模型的可信度进行检验; (iii)判断每个自变量 x (i 1,2, ,m) i = L 对 y 的影响是否显著; (iv)诊断回归模型是否适合这组数据; (v)利用回归模型对 y 进行预报或控制。 §1 数据表的基础知识 1.1 样本空间 在本章中,我们所涉及的均是样本点×变量类型的数据表。如果有 m 个变量 m x , x , , x 1 2 L ,对它们分别进行了 n 次采样(或观测),得到n 个样本点 ( , , , ) i1 i2 im x x L x ,i =1,2,L, n 则所构成的数据表 X 可以写成一个 n× m 维的矩阵。 ⎥ ⎥ ⎥ ⎦ ⎤ ⎢ ⎢ ⎢ ⎣ ⎡ = × = T n T ij n m e e X x M 1 ( ) 式中 T m ei = (xi1, xi2 ,L, xim ) ∈ R ,i = 1,2,L, n , i e 被称为第i 个样本点。 样本的均值为 ( , , , ) 1 2 m x = x x L x , ∑= = n i j ij x n x 1 1 , j = 1,2,L,m 样本协方差矩阵及样本相关系数矩阵分别为 T k n k ij m m k e x e x n S s ( )( ) 1 1 ( ) 1 − − − = = ∑= × ⎟ ⎟ ⎠ ⎞ ⎜ ⎜ ⎝ ⎛ = × = ii jj ij ij m m s s s R (r ) 其中

12(。-) n- 数据的中心化处理是指平移变换,即 x=xm-x,i=1,2,.,n:j=l,2,.,m 该变换可以使样本的均值变为0,而这样的变换既不改变样本点间的相互位置,也 不改变变量间的相关性。但变换后,却常常有许多技术上的便利。 (2)数据的无量纲化处理 在实际问题中,不同变量的测量单位往往是不一样的。为了消除变量的量纲效应 使每个变最都具有同等的表现力,数据分析中常用的消量纲的方法,是对不同的变量进 行所谓的压缩处理,即使每个变量的方差均变成1,即 x =x/s x,-, 其中s,=n-1 还可以有其它消量纲的方法,如 xy=x/max(xo),x=xy/minx) x=x/,x=x /(maxtx)-mintx) (3)标准化处理 所谓对数据的标准化处理,是指对数据同时进行中心化一压缩处理,即 =-王,i=12,j=2,m 5 2 8 无程的型为 Y=B+Bx+E (1) 式中,B。,B为回归系数,是随机误差项,总是假设~N(0,σ2),则随机变量 y-N(B。+Bx,o2). 若对y和x分别进行了n次独立观测,得到以下n对观测值 (0y,x),i=1,2,.,n (2) 这n对观测值之间的关系符合模型 y=B。+Bx+s,i=l,2,.,n 3) 这里,x,是自变量在第1次观测时的取值,它是一个非随机变量,并且没有测量误差。 对应于x,y,是一个随机变量,它的随机性是由,造成的。6,~N(0,G),对于不同 的观测,当i≠广时,6,与6,是相互独立的。 2.2最小二乘估计方法 -227

-227- ∑= − − − = n k ij ki i kj j x x x x n s 1 ( )( ) 1 1 1.2 数据的标准化处理 (1)数据的中心化处理 数据的中心化处理是指平移变换,即 ij ij j x = x − x * ,i = 1,2,L, n ; j = 1,2,L,m 该变换可以使样本的均值变为 0,而这样的变换既不改变样本点间的相互位置,也 不改变变量间的相关性。但变换后,却常常有许多技术上的便利。 (2)数据的无量纲化处理 在实际问题中,不同变量的测量单位往往是不一样的。为了消除变量的量纲效应, 使每个变量都具有同等的表现力,数据分析中常用的消量纲的方法,是对不同的变量进 行所谓的压缩处理,即使每个变量的方差均变成 1,即 ij ij j x x / s * = 其中 ∑= − − = n i j ij j x x n s 1 2 ( ) 1 1 。 还可以有其它消量纲的方法,如 / max{ } * ij i ij ij x = x x , / min{ } * ij i ij ij x = x x ij ij j x x / x * = , /(max{ } min{ }) * ij i ij i ij ij x = x x − x (3)标准化处理 所谓对数据的标准化处理,是指对数据同时进行中心化-压缩处理,即 j ij j ij s x x x − =* ,i = 1,2,L, n , j = 1,2,L,m。 §2 一元线性回归 2.1 模型 一元线性回归的模型为 y = β + β x + ε 0 1 , (1) 式中, 0 1 β ,β 为回归系数, ε 是随机误差项,总是假设 ~ (0, ) 2 ε N σ ,则随机变量 ~ ( , ) 2 y N β 0 + β1x σ 。 若对 y 和 x 分别进行了n 次独立观测,得到以下 n 对观测值 ( , ) i i y x ,i = 1,2,L, n (2) 这n 对观测值之间的关系符合模型 i i y = β + β x + ε 0 1 ,i = 1,2,L, n (3) 这里, i x 是自变量在第i 次观测时的取值,它是一个非随机变量,并且没有测量误差。 对应于 i x , i y 是一个随机变量,它的随机性是由 i ε 造成的。 ~ (0, ) 2 ε i N σ ,对于不同 的观测,当i ≠ j 时, i ε 与 j ε 是相互独立的。 2.2 最小二乘估计方法

2.2.1最小二乘法 用最小二乘法估计B。,B的值,即取B,B的一组估计值B。,B,使y与 立=B。+尼x的误差平方和达到最小。若记 QR,R)=20y-R-Rx)月 )=min(B)=x) 显然Q(B。,B)≥0,且关于B,B可微,则由多元函数存在极值的必要条件得 景-空-40 器-吃-A-40-0 整理后,得到下面的方程组 明+B2-立 (4) B2+B2-2 此方程组称为正规方程组,求解可以得到 至4-X,-列 ∑(x,-) (5) 月。=-月 称月,月为B,B的最小二乘估计,其中,元,分别是x与y的样本均值,即 关于B的计算公式还有一个更直观的表示方法,即 x-0y-列 三。- -28

-228- 2.2.1 最小二乘法 用最小二乘法估计 0 1 β , β 的值,即取 0 1 β , β 的一组估计值 0 1 ˆ , ˆ β β ,使 i y 与 y x i 0 1 ˆ ˆ ˆ = β + β 的误差平方和达到最小。若记 ∑= = − − n i i i Q y x 1 2 0 1 0 1 (β , β ) ( β β ) 则 ∑= = = − − n i i i Q Q y x 1 2 0 1 0 1 , 0 1 ) ˆ ˆ ) min ( , ) ( ˆ , ˆ ( 0 1 β β β β β β β β 显然Q(β 0 , β1) ≥ 0 ,且关于 0 1 β , β 可微,则由多元函数存在极值的必要条件得 2 ( ) 0 1 0 1 0 = − − − = ∂ ∂ ∑= n i i i y x Q β β β 2 ( ) 0 1 0 1 1 = − − − = ∂ ∂ ∑= n i i i i x y x Q β β β 整理后,得到下面的方程组 ⎪ ⎪ ⎩ ⎪ ⎪ ⎨ ⎧ + = + = ∑ ∑ ∑ ∑ ∑ = = = = = n i i i n i i n i i n i i n i i x x x y n x y 1 1 2 1 1 0 1 1 0 1 β β β β (4) 此方程组称为正规方程组,求解可以得到 ⎪ ⎪ ⎪ ⎩ ⎪ ⎪ ⎪ ⎨ ⎧ = − − − − = ∑ ∑ = = y x x x x x y y n i i n i i i 0 1 1 2 1 1 ˆ ˆ ( ) ( )( ) ˆ β β β (5) 称 0 1 ˆ , β ˆ β 为 0 1 β , β 的最小二乘估计,其中, x, y 分别是 i x 与 i y 的样本均值,即 ∑= = n i i x n x 1 1 , ∑= = n i i y n y 1 1 关于 β1 的计算公式还有一个更直观的表示方法,即 ∑ ∑ = = − − − = n i i n i i i x x x x y y 1 2 1 1 ( ) ( )( ) ˆ β

2y- 2属-0-列 2-、 式中=2化-矿,0-那,与是x与的本关系数 n-1 显然,当x,y都是标准化数据时,则有x=0,=0,S,=1,S,=1。所以, 月。=0,月= 回归方程为 少=rnx 由上可知,对标准化数据,户可以表示y与x的相关程度, 2.2.2B,月的性质 作为一个随机变量,户有以下性质。 1.月是y,的线性组合,它可以写成 戊-立y 式中,店是因定的常量,飞。一无 传-切 证明事实上 A0月-%-空4司 Su-n x- 由于 2化-)=成-m)=0 所以 月= 2.因为月是随机变量y,=1,2,n)的线性组合,而y是相互独立、且服从正 态分布的,所以,月的抽样分布也服从正态分布。 3.点估计量B是总体参数B的无偏估计,有 -229

-229- ∑ ∑ ∑ ∑ ∑ = = = = = − − − − ⋅ − − = n i i n i i n i i i n i i n i i x x y y x x y y x x y y 1 2 1 2 1 1 2 1 2 ( ) ( ) ( )( ) ( ) ( ) xy x y r s s = 式中 ∑= − − = n i x i x x n s 1 2 2 ( ) 1 1 , ∑= − − = n i y i y y n s 1 2 2 ( ) 1 1 , xy r 是 x 与 y 的样本相关系数。 显然,当 i i x , y 都是标准化数据时,则有 x = 0 , y = 0 , sx = 1, s y =1。所以, 有 0 ˆ β 0 = , xy = r 1 β ˆ 回归方程为 y r x = xy ˆ 由上可知,对标准化数据, 1 β ˆ 可以表示 y 与 x 的相关程度。 2.2.2 0 1 ˆ , β ˆ β 的性质 作为一个随机变量, 1 β ˆ 有以下性质。 1. 1 β ˆ 是 i y 的线性组合,它可以写成 ∑= = n i i i k y 1 1 β ˆ (6) 式中, i k 是固定的常量, ∑= − − = n i i i i x x x x k 1 2 ( ) 。 证明 事实上 ∑ ∑ ∑ ∑ ∑ = = = = = − − − − = − − − = n i i n i n i i i i n i i n i i i x x x x y y x x x x x x y y 1 2 1 1 1 2 1 1 ( ) ( ) ( ) ( ) ( )( ) β ˆ 由于 ( ) ( ) 0 1 ∑ − = − = = y x x y nx nx n i i 所以 i n i n i i i y x x x x ∑ ∑= = − − = 1 1 2 1 ( ) β ˆ 2.因为 1 β ˆ 是随机变量 y (i 1,2, , n) i = L 的线性组合,而 i y 是相互独立、且服从正 态分布的,所以, 1 β ˆ 的抽样分布也服从正态分布。 3.点估计量 1 β ˆ 是总体参数 β1 的无偏估计,有

Ba=4空小-26B -kE(B+B)=B+B 由于 含. x-空 属-x- 4 -=l 云2- 所以 E(B)=B 4.估计量月的方差为 Var(B)= 02 (7) 2- 这是因为 Var()-VarVar(. 由于 - 1 x-= 1 2:-白 - 因此,式(7)得证。 5.对于总体模型中的参数B,在它的所有线性无偏估计量中,最小二乘估计最房 其有最小的方差。 记任意一个线性估计量 店-2x 式中C是任意常数,C不全为零,i=1,2,n。要求月,是B的无偏估计量,即 E(a)=∑c,EOy,)=B 另一方面,由于Ey,)=B。+Bx,所以又可以写成 -230-

-230- ∑ ∑ = = ⎟ = ⎠ ⎞ ⎜ ⎝ ⎛ = n i i i n i i i E E k y k E y 1 1 1 ) ( ) ˆ (β ∑ ∑ ∑ = = = = + = + n i i i n i i i n i i k E x k k x 1 1 1 0 1 0 1 (β β ) β β 由于 0 ( ) 1 1 1 2 = − − = ∑ ∑ ∑ = = = n i n i i i n i i x x x x k 1 ( ) ( )( ) ( ) 1 2 1 1 1 1 2 = − − − = − − = ∑ ∑ ∑ ∑ ∑ = = = = = n i i n i i i i n i n i i i i n i i x x x x x x x x x x x k x 所以 1 1 ) ˆ E(β = β 4.估计量 1 β ˆ 的方差为 ∑= − = n i i x x 1 2 2 1 ( ) ) ˆ Var( σ β (7) 这是因为 ∑ ∑ ∑ ∑ = = = = ⎟ = = = ⎠ ⎞ ⎜ ⎝ ⎛ = n i i n i i n i i i n i i i k y k y k k 1 2 2 1 2 2 1 2 1 1 ) Var Var( ) ˆ Var(β σ σ 由于 ∑ ∑ ∑ ∑ ∑ ∑ = = = = = = − − = ⎥ ⎦ ⎤ ⎢ ⎣ ⎡ − = − − = n i i n i i n i i n i n i i i n i i x x x x x x x x x x k 1 1 2 2 2 1 2 1 2 1 1 2 2 ( ) 1 ( ) ( ) 1 ) ( ) ( 因此,式(7)得证。 5.对于总体模型中的参数 β1 ,在它的所有线性无偏估计量中,最小二乘估计量 1 β ˆ 具有最小的方差。 记任意一个线性估计量 ∑= = n i i i c y 1 1 ~ β 式中 i c 是任意常数, i c 不全为零,i = 1,2,L, n 。要求 1 ~ β 是 β1 的无偏估计量,即 1 1 1 ) ( ) ~ (β = ∑ = β = n i i i E c E y 另一方面,由于 i i E y x 0 1 ( ) = β + β ,所以又可以写成

E(B)=c(B+Bx)=B2c+B2cx 为保证无偏性,C,要满足下列限制 =0.2c=0 定义c,=k+d,其中k,是式(6)中的组合系数,d,是任意常数,则 Var(a)=a∑c=o∑好+2d+22kd 由于 a-2-心字8 经-站写 1 - 1一=0 %-x- σ2∑k= 2 -=Var(B) x- 所以 Var(a)=Var(A)+a∑d 三心的最小值为零,所以,当它-0时月的方老最小,自是,只有告d=0 时,即C=时,才有∑d=0。所以,最小二乘估计最在所有无偏估计量中具 有最小的方差。 同理,可以得出相应于点估计量的统计性质。对于一元线性正态误差回归模型 来说,最小二乘估计量B,是y,的线性组合,所以,它的抽样分布也是正态的。它是总 体参数民的无偏估计量,即 E(月)=R 同样可以证明 ar)=o22+ (8) -231-

-231- ∑ ∑ ∑ = = = = + = + n i i i n i i n i i i E c x c c x 1 1 1 0 1 1 0 1 ) ( ) ~ (β β β β β 为保证无偏性, i c 要满足下列限制 0 1 ∑ = = n i i c , 0 1 ∑ = = n i i i c x 定义 i i di c = k + ,其中 i k 是式(6)中的组合系数, di 是任意常数,则 ⎟ ⎠ ⎞ ⎜ ⎝ ⎛ = ∑ = ∑ +∑ + ∑ = = = = n i i i n i i n i i n i i c k d k d 1 1 2 1 2 2 1 2 2 1 ) 2 ~ Var(β σ σ 由于 ∑ ∑ ∑ ∑ ∑ = = = = = − − − = − = n i n i n i i i i i n i i i i n i i i k x x x x k d k c k c 1 1 2 1 1 1 2 ( ) ( ) 0 ( ) 1 ( ) 1 ( ) 1 2 1 1 2 2 1 2 1 1 = − − − − = − − = ∑ ∑ ∑ ∑ ∑ ∑ = = = = = = n i i n i i n i n i i i n i i n i i i x x x x k x x c x x c 而 ) ˆ Var( ( ) 1 1 2 2 1 2 2 β σ σ = − = ∑ ∑ = = n i i n i i x x k 所以 ∑= = + n i di 1 2 2 1 1 ) ˆ ) Var( ~ Var(β β σ ∑= n i di 1 2 的最小值为零,所以,当∑= = n i di 1 2 0 时, 1 ~ β 的方差最小。但是,只有当di ≡ 0 时,即 i i c ≡ k 时,才有 ∑= = n i di 1 2 0 。所以,最小二乘估计量 1 β ˆ 在所有无偏估计量中具 有最小的方差。 同理,可以得出相应于点估计量 0 β ˆ 的统计性质。对于一元线性正态误差回归模型 来说,最小二乘估计量 0 β ˆ 是 i y 的线性组合,所以,它的抽样分布也是正态的。它是总 体参数 β 0 的无偏估计量,即 0 0 ) ˆ E(β = β 同样可以证明 ] ( ) 1 ) [ ˆ ( 1 2 2 2 0 ∑= − = + n i i x x x n Var β σ (8)

且。是B,的线性无偏的最小方差估计最。 1.残差和为零。 残差 -2 2e=2y-A-x)=0 9 2.拟合值戈,的平均值等于观测值y,的平均值,即 乞=2y= (10) 按照第一正规方程,有 2y-成-x)=0 所以 立-2a+x-立 3.当第次试验的残差以相应的自变量取值为权重时,其加权残差和为零,即 多g0 (11) 这个结论由第二个正规方程∑x(y一序。一月x)=0即可得出。 4.当第1次试验的残差以相应的因变量的拟合值为权重时,其加权残差和为零 即 26-0 (12) 这是因为 2(成+xg,=a2e,+2xg=0 5.最小二乘回归线总是通过观测数据的重心(任,)的。 事实上,当自变量取值为下时,由式(5) 月。=-Bx 所以 =B。+Bx=(下-Bx)+Bx= 2.3拟合效果分析 当根据一组观测数据得到最小二乘拟合方程后,必须考察一下,是否真的能由所得 -232-

-232- 且 0 β ˆ 是 β 0 的线性无偏的最小方差估计量。 2.2.3 其它性质 用最小二乘法拟合的回归方程还有一些值得注意的性质: 1.残差和为零。 残差 i i i e = y − yˆ ,i = 1,2,L, n 由第一个正规方程,得 ) 0 ˆ ˆ ( 1 0 1 1 1 ∑ = ∑ − − = = = n i i n i i e y β β x (9) 2.拟合值 i yˆ 的平均值等于观测值 i y 的平均值,即 y y n y n n i i n i ∑ i = ∑ = =1 =1 1 ˆ 1 (10) 按照第一正规方程,有 ) 0 ˆ ˆ ( 1 ∑ − 0 − 1 = = n i i i y β β x 所以 ∑ ∑ ∑ = = = = + = n i i n i i n i i y x y 1 1 0 1 1 ) ˆ ˆ ˆ (β β 3.当第i 次试验的残差以相应的自变量取值为权重时,其加权残差和为零,即 0 1 ∑ = = n i i i x e (11) 这个结论由第二个正规方程 ) 0 ˆ ˆ ( 1 ∑ − 0 − 1 = = n i i i i x y β β x 即可得出。 4.当第i 次试验的残差以相应的因变量的拟合值为权重时,其加权残差和为零, 即 ˆ 0 1 ∑ = = i n i i y e (12) 这是因为 0 ˆ ˆ ) ˆ ˆ ( 1 1 1 0 1 ∑ 0 + 1 = ∑ + ∑ = = = = n i i i n i i n i i i β β x e β e β x e 5.最小二乘回归线总是通过观测数据的重心(x, y)的。 事实上,当自变量取值为 x 时,由式(5) y x 0 1 β ˆ β ˆ = − 所以 y = + x = y − x + x = y 0 1 1 1 ˆ ) ˆ ( ˆ ˆ ˆ β β β β 2.3 拟合效果分析 当根据一组观测数据得到最小二乘拟合方程后,必须考察一下,是否真的能由所得

的模型(乃=房。+x)来较好地拟合观测值y?用戈=月。+序x,能否较好地反映 (或者说解释)y,值的取值变化?回归方程的质量如何?误差多大?对这些,都必须 予以正确的评估和分析。 2.3.1残差的样木方差 记残差 e=y-元,i=1,2.,n 残差的样本均值为 e-20-1-0 残差的样本方差为 MSE=- 2-时22w- 由于有∑e,=0和∑xe,=0的约束,所以,残差平方和有(n-2)个自由度。可 以证明,在对∑c2除以其自由度(n-2)后得到的MSE,是总体回归模壁中 c2=ar(G)的无偏估计量。记 S-=2 (13) 一个好的合方程,其残弟总和应越小越好。残差越小。拟合值与观测值越接近 各观测点在拟合直线周围聚集的紧密程度越高,也就是说,拟合方程少=。+x解 y的能力越强。 另外,当S。越小时,还说明残差值,的变异程度越小。由于残差的样本均值为零, 所以,其离散范围 拟合的模型就越为精确。 2 判定系数 (拟合优度 对应于不同的x,值,观测值y,的取值是不同的。建立一元线性回归模型的目的, 就是试图以x的线性函数(。+序x)来解释y的变异。那么,回归模型少=月。+月, 究竟能以多大的精度来解释y的变异呢?又有多大部分是无法用这个回归方程来解释 的呢? 乃,片,.,的变异程度可采用样本方差来测度,即 =20-㎡ 根据式(10),拟合值,乃,立的均值也是,其变异程度可以用下式测度 2= 2成- 下面看一下52与2之间的关系,有 -23

-233- 的模型( i i y x 0 1 ˆ ˆ ˆ = β + β )来较好地拟合观测值 i y ?用 i i y x 0 1 ˆ ˆ ˆ = β + β 能否较好地反映 (或者说解释) i y 值的取值变化?回归方程的质量如何?误差多大?对这些,都必须 予以正确的评估和分析。 2.3.1 残差的样本方差 记残差 i i i e = y − yˆ ,i =1,2,L, n 残差的样本均值为 ( ˆ ) 0 1 1 = ∑ − = = n i i i y y n e 残差的样本方差为 ∑ ∑ ∑ = = = − − = − − = − = n i i i n i i n i i y y n e n e e n MSE 1 2 1 2 1 2 ( ˆ ) 2 1 2 1 ( ) 2 1 由于有 0 1 ∑ = = n i i e 和 0 1 ∑ = = n i i i x e 的约束,所以,残差平方和有(n − 2)个自由度。可 以证明,在对 ∑= n i i e 1 2 除以其自由度 (n − 2) 后得到的 MSE ,是总体回归模型中 ( ) 2 Var i σ = ε 的无偏估计量。记 ∑ − = = = n i e i e n S MSE 1 2 2 1 (13) 一个好的拟合方程,其残差总和应越小越好。残差越小,拟合值与观测值越接近, 各观测点在拟合直线周围聚集的紧密程度越高,也就是说,拟合方程 y x 0 1 ˆ ˆ ˆ = β + β 解释 y 的能力越强。 另外,当 Se 越小时,还说明残差值 i e 的变异程度越小。由于残差的样本均值为零, 所以,其离散范围越小,拟合的模型就越为精确。 2.3.2 判定系数(拟合优度) 对应于不同的 i x 值,观测值 i y 的取值是不同的。建立一元线性回归模型的目的, 就是试图以 x 的线性函数( x 0 1 β ˆ β ˆ + )来解释 y 的变异。那么,回归模型 y x 0 1 ˆ ˆ ˆ = β + β 究竟能以多大的精度来解释 y 的变异呢?又有多大部分是无法用这个回归方程来解释 的呢? n y , y , , y 1 2 L 的变异程度可采用样本方差来测度,即 ∑= − − = n i i y y n s 1 2 2 ( ) 1 1 根据式(10),拟合值 n yˆ , yˆ , , yˆ 1 2 L 的均值也是 y ,其变异程度可以用下式测度 ∑= − − = n i i y y n s 1 2 2 ( ˆ ) 1 1 ˆ 下面看一下 2 s 与 2 sˆ 之间的关系,有

,-列=0y-+2成-列+220y-列 由于 20y-X0-列=卫0y-成-x成+-列 =A20-成-x)+20-A-x)-20-成-x)=0 因此,得到正交分解式为 20%-2-列+20-》 (14) SST-∑0,-可2,这是原始数据y的总变异平方和,其自由度为d,=n-1: SSR=立0-列,这是用拟合直线元=成+可解释的变异平方和,其自 由度为d=1: SSE=∑0-,)2,这是残差平方和,其的自由度为d:=n-2. 所以,有 SST=SSR+SSE,df=df+ 从上式可以看出,y的变异是由两方面的原因引起的:一是由于x的取值不同,而 给y带来的系统性变异;另一个是由除x以外的其它因素的影响。 注意到对于一个确定的样本(一组实现的观测值),SST是一个定值。所以,可解 释变异SSR越大,则必然有残差SSE越小。这个分解式可同时从两个方面说明拟合方 程的优良程度: (1)SS℉越大,用回归方程来解释片变异的部分越大,回归方程对原数据解释得 越好。 (2)SSE越小,观利估以绕回归直线越紧密,回归方程对原数据的拟合效果越好 判定系数是指可解释的变异占总变异的百分比,用R表示,有 R==1- (15) T T 从判定系数的定义看,R有以下简单性质: (1)0≤R2≤1: (2)当R=1时,有SSR=SST,也就是说,此时原数据的总变异完全可以由拟 合值的变异来解释,并且残差为零(SSE=0),即拟合点与原数据完全吻合: (3)当R=0时,回归方程完全不能解释原数据的总变异,y的变异完全由与x 24

-234- ∑ ∑ ∑ ∑ = = = = − = − + − + − − n i i i i n i i n i i i n i i y y y y y y y y y y 1 1 2 1 2 1 2 ( ) ( ˆ ) ( ˆ ) 2 ( ˆ )( ˆ ) 由于 ∑ ∑ = = − − = − − + − n i i i i n i i i i y y y y y x x y 1 0 1 0 1 1 ) ˆ ˆ )( ˆ ˆ ( ˆ )( ˆ ) ( β β β β ) 0 ˆ ˆ ) ( ˆ ˆ ( ˆ ) ˆ ˆ ( ˆ 1 0 1 1 1 0 1 1 = 0∑ − 0 − 1 + ∑ − − − ∑ − − = = = = n i i i n i i i i n i i i β y β β x β x y β β x y y β β x 因此,得到正交分解式为 ∑ ∑ ∑ = = = − = − + − n i i i n i i n i i y y y y y y 1 2 1 2 1 2 ( ) ( ˆ ) ( ˆ ) (14) 记 ∑= = − n i i SST y y 1 2 ( ) ,这是原始数据 i y 的总变异平方和,其自由度为 df = n −1 T ; ∑= = − n i i SSR y y 1 2 ( ˆ ) ,这是用拟合直线 i i y x 0 1 ˆ ˆ ˆ = β + β 可解释的变异平方和,其自 由度为 = 1 R df ; ∑= = − n i i i SSE y y 1 2 ( ˆ ) ,这是残差平方和,其的自由度为 df = n − 2 E 。 所以,有 SST = SSR + SSE , T R E df = df + df 从上式可以看出,y 的变异是由两方面的原因引起的;一是由于 x 的取值不同,而 给 y 带来的系统性变异;另一个是由除 x 以外的其它因素的影响。 注意到对于一个确定的样本(一组实现的观测值),SST 是一个定值。所以,可解 释变异 SSR 越大,则必然有残差 SSE 越小。这个分解式可同时从两个方面说明拟合方 程的优良程度: (1)SSR 越大,用回归方程来解释 i y 变异的部分越大,回归方程对原数据解释得 越好; (2)SSE 越小,观测值 i y 绕回归直线越紧密,回归方程对原数据的拟合效果越好。 因此,可以定义一个测量标准来说明回归方程对原始数据的拟合程度,这就是所谓 的判定系数,有些文献上也称之为拟合优度。 判定系数是指可解释的变异占总变异的百分比,用 2 R 表示,有 (1 ) 2 SST SSE SST SSR R = = − (15) 从判定系数的定义看, 2 R 有以下简单性质: (1)0 1 2 ≤ R ≤ ; (2)当 1 2 R = 时,有 SSR = SST ,也就是说,此时原数据的总变异完全可以由拟 合值的变异来解释,并且残差为零( SSE = 0 ),即拟合点与原数据完全吻合; (3)当 0 2 R = 时,回归方程完全不能解释原数据的总变异, y 的变异完全由与 x

无关的因素引起,这时SSE=SST。 测定系数时一个很有趣的指标:一方面它可以从数据变异的角度指出可解释的变异 占总变异的百分比,从而说明回归直线拟合的优良程度:另一方面,它还可以从相关性 的角度,说明原因变量y与拟合变量少的相关程度,从这个角度看,拟合变量少与原 变量y的相关度越大,拟合直线的优良度就越高。 看下面的式子 R=SSR 2-列2成+e-列 SST =r2y,)(16) 20-2-列6所-列 在推导中,注意有 ∑e-列=2e成-2e=0 所以,R又等于y与拟合变量的相关系数平方。 还可以证明,√R2等于y与自变量x的相关系数,而相关系数的正、负号与回归 系数月的符号相同。 24显苦性检验 2.4.1回归模型的线性关系检验 在拟合回归方程之前,我们曾假设数据总体是符合线性正态误差模型的,也就是说, y与x之间的关系是线性关系,即 y=月+月x+,6,~N(0,2),i=1,2,.,n 然而,这种假设是否真实,还需进行检验。 对于一个实际观测的样本,虽然可以用判定系数R说明y与少的相关程度,但是, 样本测度指标具有一定的随机因素,还不足以肯定y与x的线性关系。 假设y与x之问存在线性关系,则总体模型为 y=B+Bx+6,i=1,2.,n 加果B.去0。则称这个模刑为全模型。 用最小二乘法拟合全模型,并求出误差平方和为 SSE-.-) 现给出假设H:B=0。如果H。假设成立,则 y,=B+6, 这个模型被称为选模型。用最小二乘法拟合这个模型,则有 月=0 B。=-Bx= 因此,对所有的i=1,2,.,n,有 -235

-235- 无关的因素引起,这时 SSE = SST 。 测定系数时一个很有趣的指标:一方面它可以从数据变异的角度指出可解释的变异 占总变异的百分比,从而说明回归直线拟合的优良程度;另一方面,它还可以从相关性 的角度,说明原因变量 y 与拟合变量 yˆ 的相关程度,从这个角度看,拟合变量 yˆ 与原 变量 y 的相关度越大,拟合直线的优良度就越高。 看下面的式子 ( , ˆ) ( ) ( ˆ ) ( ˆ )( ˆ ) ( ) ( ˆ ) 2 1 2 1 2 2 1 1 2 1 2 2 r y y y y y y y e y y y y y y y SST SSR R n i i n i i n i i i i n i i n i i = − − ⎥ ⎦ ⎤ ⎢ ⎣ ⎡ + − − = − − = = ∑ ∑ ∑ ∑ ∑ = = = = = (16) 在推导中,注意有 ( ˆ ) ˆ 0 1 1 1 ∑ − = ∑ − ∑ = = = = n i i n i i i n i i i e y y e y y e 所以, 2 R 又等于 y 与拟合变量 yˆ 的相关系数平方。 还可以证明, 2 R 等于 y 与自变量 x 的相关系数,而相关系数的正、负号与回归 系数 1 β ˆ 的符号相同。 2.4 显著性检验 2.4.1 回归模型的线性关系检验 在拟合回归方程之前,我们曾假设数据总体是符合线性正态误差模型的,也就是说, y 与 x 之间的关系是线性关系,即 i i i y = β + β x + ε 0 1 , ~ (0, ) 2 ε i N σ ,i =1,2,L, n 然而,这种假设是否真实,还需进行检验。 对于一个实际观测的样本,虽然可以用判定系数 2 R 说明 y 与 yˆ 的相关程度,但是, 样本测度指标具有一定的随机因素,还不足以肯定 y 与 x 的线性关系。 假设 y 与 x 之间存在线性关系,则总体模型为 i i i y = β + β x + ε 0 1 ,i = 1,2,L, n 如果 0 β1 ≠ ,则称这个模型为全模型。 用最小二乘法拟合全模型,并求出误差平方和为 ∑= = − n i i i SSE y y 1 2 ( ˆ ) 现给出假设 H0 : β1 = 0。如果 H0 假设成立,则 i i y = β + ε 0 这个模型被称为选模型。用最小二乘法拟合这个模型,则有 0 ˆ β1 = = y − x = y 0 0 β ˆ β ˆ 因此,对所有的i = 1,2,L, n ,有

按次数下载不扣除下载券;

注册用户24小时内重复下载只扣除一次;

顺序:VIP每日次数-->可用次数-->下载券;

- 《数学模型与数学实验》课程书籍文献(数学建模算法大全)第11章 方差分析.pdf

- 《数学模型与数学实验》课程书籍文献(数学建模算法大全)第10章 数据的统计描述和分析.pdf

- 《数学模型与数学实验》课程书籍文献(数学建模算法大全)第09章 插值与拟合.pdf

- 《数学模型与数学实验》课程书籍文献(数学建模算法大全)第08章 层次分析法.pdf

- 《数学模型与数学实验》课程书籍文献(数学建模算法大全)第07章 对策论.pdf

- 《数学模型与数学实验》课程书籍文献(数学建模算法大全)第06章 排队论.pdf

- 《数学模型与数学实验》课程书籍文献(数学建模算法大全)第05章 图与网络.pdf

- 《数学模型与数学实验》课程书籍文献(数学建模算法大全)第04章 动态规划.pdf

- 《数学模型与数学实验》课程书籍文献(数学建模算法大全)第03章 非线性规划.pdf

- 《数学模型与数学实验》课程书籍文献(数学建模算法大全)第02章 整数规划.pdf

- 《数学模型与数学实验》课程书籍文献(数学建模算法大全)第01章 线性规划.pdf

- 《经济数学基础》课程PPT教学课件(概率统计)课程辅助信息.ppt

- 《经济数学基础》课程PPT教学课件(线性代数)第三章 向量空间(3/4).ppt

- 重庆工商大学:《经济数学基础》课程教学资源(作业习题)概率统计(习题).doc

- 《经济数学基础》课程教学资源(作业习题)概率统计习题(无答案).doc

- 重庆工商大学:《经济数学基础》课程教学资源(作业习题)线性代数及概率统计(答案).doc

- 重庆工商大学:《经济数学基础》课程教学资源(作业习题)线性代数(习题).doc

- 重庆工商大学:《经济数学基础》课程教学资源(作业习题)微积分(答案).doc

- 重庆工商大学:《经济数学基础》课程教学资源(作业习题)微积分(习题).doc

- 《经济数学基础》课程教学资源(PPT讲稿)实验3 螺旋线与平面的交点.ppt

- 《数学模型与数学实验》课程书籍文献(数学建模算法大全)第13章 微分方程建模.pdf

- 《数学模型与数学实验》课程书籍文献(数学建模算法大全)第14章 稳定状态模型.pdf

- 《数学模型与数学实验》课程书籍文献(数学建模算法大全)第15章 常微分方程的解法.pdf

- 《数学模型与数学实验》课程书籍文献(数学建模算法大全)第16章 差分方程模型.pdf

- 《数学模型与数学实验》课程书籍文献(数学建模算法大全)第17章 马氏链模型.pdf

- 《数学模型与数学实验》课程书籍文献(数学建模算法大全)第18章 变分法模型.pdf

- 《数学模型与数学实验》课程书籍文献(数学建模算法大全)第19章 神经网络模型.pdf

- 《数学模型与数学实验》课程书籍文献(数学建模算法大全)第20章 偏微分方程的数值解.pdf

- 《数学模型与数学实验》课程书籍文献(数学建模算法大全)第21章 目标规划.pdf

- 《数学模型与数学实验》课程书籍文献(数学建模算法大全)第22章 模糊数学模型.pdf

- 《数学模型与数学实验》课程书籍文献(数学建模算法大全)第23章 现代优化算法.pdf

- 《数学模型与数学实验》课程书籍文献(数学建模算法大全)第24章 时间序列模型.pdf

- 《数学模型与数学实验》课程书籍文献(数学建模算法大全)第25章 存贮论.pdf

- 《数学模型与数学实验》课程书籍文献(数学建模算法大全)第26章 经济与金融中的优化问题.pdf

- 《数学模型与数学实验》课程书籍文献(数学建模算法大全)第27章 生产与服务运作管理中的优化问题.pdf

- 《数学模型与数学实验》课程书籍文献(数学建模算法大全)第28章 灰色系统理论及其应用.pdf

- 《数学模型与数学实验》课程书籍文献(数学建模算法大全)第29章 多元分析.pdf

- 《数学模型与数学实验》课程书籍文献(数学建模算法大全)第30章 偏最小二乘回归.pdf

- 《数学模型与数学实验》课程书籍文献(数学建模算法大全)附录一 Matlab入门.pdf

- 《数学模型与数学实验》课程书籍文献(数学建模算法大全)附录三 运筹学的LINGO软件.pdf